Kafka实战指引 实时海量流式数据处理与存储支持服务

随着业务规模的扩大和数据量的爆炸式增长,实时处理海量流式数据已成为现代企业不可或缺的能力。Apache Kafka作为分布式流式数据平台,凭借其高吞吐、低延迟、可扩展等特性,成为处理实时数据流的首选工具之一。本文将从实战角度出发,结合数据处理和存储支持服务,系统介绍Kafka的应用场景与操作指南。

一、Kafka核心概念与架构

Kafka是一种高吞吐量的分布式发布订阅消息系统,能够处理海量数据流。其架构主要由生产者(Producer)、消费者(Consumer)、主题(Topic)、分区(Partition)和代理(Broker)等组件构成。生产者负责将数据发布到Kafka集群,消费者从集群订阅并消费数据,而主题则作为数据流的逻辑分类。分区机制不仅提升了并行处理能力,还实现了数据的负载均衡和容错。

二、实时海量流式数据处理实战

在实时数据处理场景中,Kafka常与流处理框架如Apache Flink、Apache Spark Streaming或Kafka Streams结合使用。以下是实战中的关键步骤:

- 数据采集与接入:通过Kafka生产者将来自日志、传感器、事务系统等源头的数据实时推送到Kafka主题。

- 流处理:利用Kafka Streams或集成外部流处理引擎,对数据进行实时转换、聚合和过滤。例如,在电商平台中实时计算用户点击率或库存变化。

- 数据分发:处理后的结果可被多个消费者订阅,用于实时监控、报警或下游分析。

三、数据处理与存储支持服务

Kafka不仅支持实时处理,还提供了可靠的数据存储与持久化机制。通过以下方式,可确保数据高效存储与后续使用:

- 数据持久化:Kafka将消息持久化到磁盘,并支持可配置的保留策略(如基于时间或大小),便于历史数据回溯。

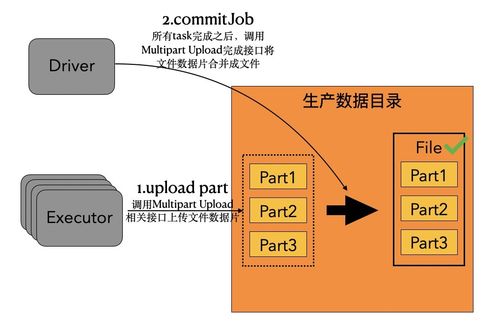

- 集成存储系统:可将Kafka与外部存储服务如Apache Hadoop、Amazon S3或关系数据库结合,实现数据的长期归档和批量分析。

- 容错与高可用:通过副本机制和故障自动转移,Kafka保障数据不丢失,支持7x24小时不间断服务。

四、最佳实践与优化建议

为充分发挥Kafka在实战中的效能,需注意以下要点:

- 合理设计主题与分区:根据数据量和吞吐需求设置分区数,避免热点问题。

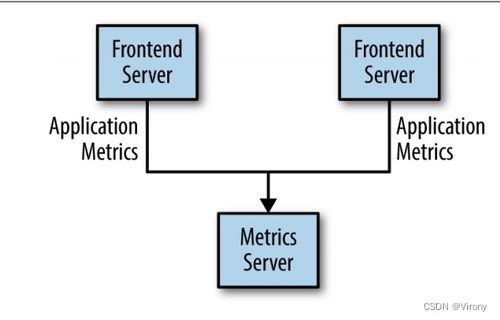

- 监控与调优:使用Kafka内置指标或第三方工具(如Prometheus)监控集群性能,调整参数如批处理大小和压缩策略。

- 安全与治理:启用SSL/SASL认证和ACL授权,确保数据安全;结合Schema Registry管理数据格式,提升兼容性。

Kafka作为实时海量流式数据处理的核心组件,结合高效的数据处理和存储支持服务,能够助力企业构建稳定、可扩展的数据流水线。通过本文的实战指引,读者可快速上手并优化自身数据架构,应对日益复杂的实时业务需求。

如若转载,请注明出处:http://www.xingfuqhd.com/product/16.html

更新时间:2026-03-03 08:09:08